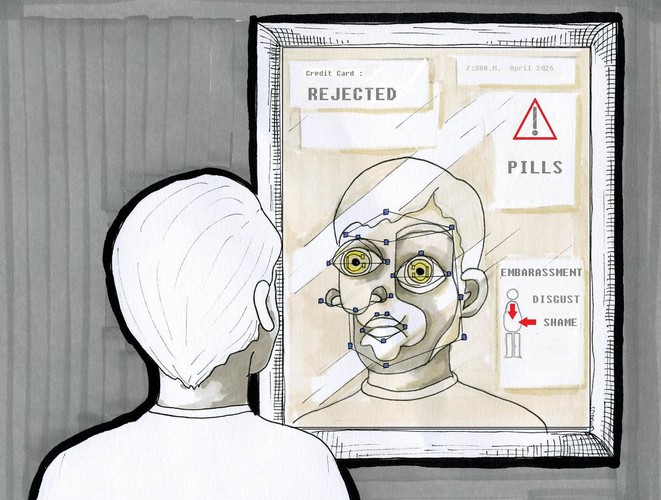

Afin de l’utiliser efficacement, l’humain aligne – consciemment puis inconsciemment – son comportement et sa pensée sur le modèle plus standard de l’IA. C’est un humain qui se robotise par anticipation. Illustration par Séverine Rebourcet ©

Lorsqu’on pense aux rapports qu’entretiennent l’humain et l’intelligence artificielle (IA), le postulat de départ est que la machine reproduit ce que l’individu fait. Or, affirme Mario Ionut Marosan, la relation inverse existe : l’humain aussi peut être amené à imiter l’IA. Dans l’optique de pouvoir utiliser l’intelligence artificielle de manière efficace, l’humain alignerait graduellement son comportement – et aussi sa pensée – sur le modèle plus standard de l’IA. Selon l’auteur, on aurait donc affaire à un humain qui se robotise par anticipation, ce qui n’est pas sans soulever des questions éthiques.

L’intelligence derrière l’«intelligence» artificielle (IA) est suspecte. Certes, nous doutons de moins en moins de ses remarquables capacités techniques. En revanche, nous doutons de plus en plus de… son intelligence.

Par exemple, nous hésitons à parler d’intelligence authentique – au sens fort du terme – quand bien même l’IA de Google nous épate en prenant rendez-vous chez le coiffeur sans nous1. Cela nous rend bien sûr service, mais est-ce réellement de l’intelligence?

Je ne m’aventurerai pas à définir l’intelligence. C’est là un terrain glissant. Cependant, je vous suggère la lecture d’un article particulièrement lucide sur le sujet, publié par Margarida Romero2.

Or, cette absence actuelle de consensus, chez les technophobes comme chez les technophiles – sans oublier ceux qui se situent entre les deux tendances – nous révèle une chose : l’intelligence, qu’elle soit artificielle ou naturelle, nous invite à la réflexion critique.

De la machine qui imite

La nature des relations entre l’homme et la machine a fait l’objet plusieurs fois de discussions de la part des érudits (et aussi des un peu moins érudits). Une question visiblement lourde de sens concentre à la fois les inquiétudes des uns et les fantasmes des autres : qui imite qui ? À priori, on serait tenté de répondre que l’IA imite l’esprit humain, sa démarche, son langage et son raisonnement.

En effet, l’IA faible comme l’IA forte reposent toutes les deux sur des algorithmes permettant à la machine d’agir rationnellement, d’où le fait que selon Jacques Baudron :

« [l’intelligence artificielle] faible, disponible aujourd’hui est celle d’un automate qui ne sait prendre de décision qu’en piochant dans ce qu’il lui a auparavant été inculqué ; l’intelligence artificielle forte que l’on espère pour demain est celle d’un humain qui décide avec sa conscience et son émotion.3 »

Qu’elle échoue (IA faible) ou qu’elle parvienne à égaler (IA forte) l’intelligence dite naturelle – voire qu’elle la dépasse – l’IA (faible comme forte) a donc toujours comme point de repère établi l’humain.

C’est ce que Pascal Chabot désigne comme une « mimesis opératoire »4. Chabot ne décortique pas le concept davantage, mais on trouve chez Adriano Fabris une démonstration plus détaillée et précise de l’imitation :

« Le concept d’ »imitation » (mimesis) est une catégorie dynamique et relationnelle. Il relie deux ou plusieurs éléments qui ont un rapport spécifique entre eux. Il s’agit d’un rapport au sein duquel on reconnaît une primauté à un élément particulier, dans la mesure où celui-ci est pris en tant que modèle […]. En d’autres termes, la « copie » est considérée comme telle dans la mesure où elle ressemble et cherche de plus en plus à ressembler, à quelque chose ou à quelqu’un pris comme « modèle ». En ceci consiste donc la dynamique de l’imitation.5 »

Essentiellement, c’est l’élément imitant (l’IA dans notre cas) qui mime le comportement de l’élément imité (l’humain) selon une méthode programmée. Toutefois, cela va encore plus loin.

De l’humain qui imite

L’humain aussi peut être amené à imiter l’IA. Supposons par exemple qu’il souhaite interagir avec une machine, il doit alors adapter sa prononciation en vue de se faire comprendre du premier coup par son assistant vocal Siri, Alexa ou Google Home. Les exemples sont aussi nombreux que les diverses interactions entre l’IA et l’humain. Pour s’en rendre compte, il suffit d’observer autour de soi (voir sur les expérimentations réalisées en psychologie cognitive).

Je propose l’adoption d’un concept en mesure d’exprimer cette réalité de l’humain moderne: le technomimétisme.

J’entends par technomimétisme le processus de modification et d’ingénierie par lequel l’humain s’inspire des formes, matières, propriétés, processus et fonctions de la technique plus généralement, et de la technologie (ainsi que de l’IA) plus spécifiquement. Il vise l’implantation – consciente et inconsciente – de la logique des machines dans la sphère d’activité du naturel.

Le technomimétisme rompt avec le biomimétisme car il vise une prévisibilité des comportements humains, alors que les systèmes naturels tendent quant à eux vers l’imprévisibilité. Il est animé par le principe suivant : être l’artiste de sa vie plutôt que de la subir comme un spectateur. Sur ce sujet, les travaux de l’historienne des sciences Bernadette Bensaude-Vincent posent une juste distinction entre biomimétisme et technomimétisme6.

L’humain, dans cette conjecture technomimétique, se dirige vers la standardisation et l’homogénéisation de son comportement. Il devra être de plus en plus prévisible – et plus robotisé – afin que l’IA puisse traiter l’information reçue rapidement. Ainsi, à quoi bon posséder quand on n’use pas de ce qu’on possède ? Autrement dit, il me semble que toute l’utilité de détenir une machine dotée d’IA repose sur le temps que celle-ci nous permet de « sauver ». Dès lors, il est évident, par exemple, que je vais en toute logique adapter mes mouvements, mes paroles – voire mes pensées éventuellement – aux normes de la machine. L’intériorisation – et l’internalisation – de ces normes va de soi lorsqu’on est dans cette dynamique d’accélération et d’optimisation du temps.

Au passage, il est pertinent de réfléchir à la question de l’(im)prédictibilité d’une IA forte. Personne, pas même les programmeurs et les ingénieurs, ne sont en mesure d’analyser par quel raisonnement l’IA forte arrive à choisir « x » plutôt que « y », ou l’inverse. À titre d’exemple, Jocelyn Maclure et Marie-Noëlle Saint-Pierre écrivent :

« [E]xpliquer, diagnostiquer et corriger ce qui pose problème dans l’algorithme est souvent impossible : la structure sous-jacente qui conduit la machine à un résultat est complexe, en particulier lorsqu’il s’agit de réseaux de neurones artificiels « profonds », c’est-à-dire comptant plusieurs couches reliées de « nœuds » qui traitent des informations différentes et qui les agrègent ensuite.7 »

En somme, il me semble que ce problème de la boîte noire se situe au niveau de la zone la plus décisive, à savoir la phase d’apprentissage qui se déploie après l’introduction des données d’entrée (input) et avant la production des données de sortie (output)8.

Or, si la machine dotée d’IA va prendre des décisions qui ont des incidences assez palpables sur la vie des individus – par exemple, selon Maclure et Saint-Pierre, accorder ou non un prêt, sélectionner des candidats pour une entrevue d’embauche, permettre ou non une libération conditionnelle, poser un diagnostic, etc.9 – n’est-il pas légitime d’exiger la transparence dans le traitement des données ? C’est là une question primordiale.

Ultimement, la mise en place de cette lecture technomimétique fait apparaître un « devenir robot chez l’humain ». Pourtant, la chose est assez peu étudiée. La contre-intuitivité d’un tel constat y est certainement pour quelque chose (l’ouvrage What Computers Still Can’t Do : A Critique of Artificial Reason de Hubert L. Dreyfus apporte des arguments précis et lucides à ce sujet).

D’où provient ce devenir robot chez l’humain ? Est-il un « malaise » de la modernité ? Existe-il depuis toujours, c’est-à-dire depuis que l’homme et la technique s’influencent mutuellement ? Que signifie-t-il concrètement ? Où va-t-il nous mener ?

Je caresse l’espoir que ces observations – et interrogations – préliminaires concernant le devenir robot de l’humain et le technomimétisme inaugureront une manière plus critique de comprendre les effets du développement fulgurant des machines dotées d’IA aujourd’hui, non seulement dans le sens que cette dernière vise à nous ressembler, mais aussi dans le sens que nous finissions – malheureusement, selon moi – par avoir des traits communs avec elle.

Nouvelles perspectives de réflexion

Considérer les rapports entre l’humain et l’IA de l’angle du technomimétisme contraste avec la plupart des études sur le sujet. Leur postulat de départ est en effet que la machine reproduit ce que l’individu fait. La relation inverse est par conséquent inconsciemment négligée (toutefois, le philosophe Charles Taylor s’est posé la question et s’y est aventuré dans son livre Human Agency and Language).

Il semble qu’une approche dynamique, c’est-à-dire qui est consciente de l’influence mutuelle exercée entre l’humain et la machine, permettra d’étudier la question éthique du développement de l’IA plus pertinemment : le développement technologique (et donc de l’IA aujourd’hui) doit devenir un moyen – de l’épanouissement humain – et non une fin en soi. Les travaux de Martin Heidegger, Ivan Illich et surtout Gilbert Simondon sur la technologie comme outil de l’humain – et non l’inverse – sont ici essentiels.

Une rencontre curieuse

Revenons à notre question initiale: qui imite qui ? Il semble que l’imitation se fait dans les deux sens, mais à différents degrés : l’IA imite l’humain automatiquement, tandis que l’humain imite l’IA (presqu’)automatiquement.

Certes, ce dernier peut encore préserver son indépendance face à la machine, mais pour combien de temps ? Il s’agit là d’une autre question assez préoccupante.

Dans l’optique de pouvoir utiliser efficacement l’intelligence artificielle, l’humain aligne – au début consciemment et ensuite plus inconsciemment – son comportement (et aussi sa pensée) sur le modèle plus standard de l’IA. On a donc affaire à un humain qui se robotise par anticipation.

Dans cette conjoncture, je constate qu’il y a à l’œuvre une dynamique relativement curieuse : alors que la recherche scientifique sur l’intelligence artificielle pousse (avec grand succès) vers un rapprochement avec l’intelligence naturelle, c’est davantage l’humain qui se rapproche (par technomimétisme) de la machine en s’alignant sur les principes de communication et les pratiques de l’IA.

Par exemple, il me semble qu’on assiste aujourd’hui à une tweeterification du langage et des échanges entre les individus, phénomène qui se traduit concrètement par plus ou moins trois tendances : (1) les discussions tendent à être de plus en plus antagonistes, d’où la recherche de plus en plus fréquente du #clash ; (2) l’argumentation exhaustive et soutenue n’est plus valorisée car seule la #punchline bien placée compte ; (3) la vie se résume de plus en plus à une série d’anecdotes qu’il faut impérativement exposer sous la forme d’un #thread à nos abonnés.

L’humain augmenté (et diminué)

Ce nivellement par le bas (technomimétique) de l’humain n’est pas sans effet. D’une manière générale, en se robotisant, il finit forcément par se déshumaniser. D’une manière précise, il profite du développement de l’IA sur le plan de l’utilité, de l’efficacité, et du rendement, tout en perdant jusqu’à un certain point des éléments qui le composent dans ce qui fait de lui un être à proprement parler imparfait, et donc tout le contraire d’un robot.

Il y aurait donc un prix à payer pour tout cela.

Prenons l’exemple de l’oubli. C’est un de ces éléments qui nous caractérisent depuis toujours, que cela nous plaise ou non. Néanmoins, à l’heure de l’IA et du numérique, on oublie jusqu’à l’existence de cette lacune. On pourrait dire que l’humain oublie l’oubli. Aujourd’hui, tout est sauvegardé dans des bases de données et la mémoire devient du coup matérielle, ce qui a pour conséquence qu’il devient (presque) impossible d’oublier.

Or, il est assez inquiétant de constater que de tels changements ne sont pas plus discutés (saluons ici le travail de Doueihi qui explore des mutations aussi subtiles dans ses travaux)10. À ma modeste connaissance, l’horizon de l’humain augmenté fait couler beaucoup plus d’encre que celui de l’humain diminué, et pourtant…

Ainsi, il me semble que l’humain qui imite un peu trop (et de trop près) l’IA s’engage peut-être dans une voie sans issue, celle d’une humanité à la fois augmentée et diminuée, tout dépendant du point de vue.

Et c’est sur cette observation que s’achève cette brève réflexion critique sur l’éthique, le développement de l’IA, et le technomimétisme de l’homme.

Il serait toutefois important que nous nous emparions davantage de la question car elle nous concerne tous. À vrai dire, le développement de l’IA n’est pas seulement l’affaire des « experts » et des investisseurs.

C’est à nous tous d’en juger.

Références:

1. Mashable Deals (9 mai 2018). Google’s AI Assistant Can Now Make Real Phone Calls. [Vidéo en ligne]. Repéré à https://www.youtube.com/watch?v=JvbHu_bVa_g

2. Margarida Romero (14 mai 2018). Intelligence artificielle et pensée humaine. The Conversation. Repéré à https://theconversation.com/intelligence-artificielle-et-pensee-humaine-96508

3. Jacques Baudron (19 avril 2018). Intelligence artificielle et pensée humaine. The Conversation. Repéré à https://theconversation.com/lemotion-talon-dachille-de-lintelligence-artificielle-95105

4. Jef Safi (7 avril 2018). Avec… Laurence Devillers et Pascal Chabot : de la nature de l’intelligence artificielle. S’ENTRE-TENIR. Repéré à http://jef-safi.net/spip/spip.php?article896

5. Adriano Fabris (15 décembre 2017). Pour une éthique de la mimesis à l’époque des technologies numériques. [Texte traduit par Enrico Agostini-Marchese et Karine Bissonnette]. Sens public. Repéré à http://sens-public.org/article1267.html?lang=fr#fn10

6. Bernadette Bensaude-Vincent (26 avril 2011). A Cultural Perspective on Biomimetics. Advances in Biomimetics, Edited by Prof. Marko Cavrak. Repéré à http://www.intechopen.com/books/advances-in-biomimetics/a-cultural-perspective-on-biomimetics

« Unlike biomimetism, technomimetism is a kind of engineering which consists in implementing the rationality of machines in natural systems. […] Simply copying nature is out of the question. Strictly speaking, nature does not teach anything. It does not deliver either lessons or recipes, which could be applied to technological projects. Nature is basically inexorable, indifferent to our projects and concerns. Living organisms may be seen as holding the answers to questions arising from biological evolution, but they cannot meet our needs resulting from military and economic competition, or societal concerns (for instance health, energy saving or pollution…). Taking inspiration from nature is a more relevant attitude, and often results in a better understanding of the differences between nature and technology. Bio-inspired designers having to elucidate the principles at work in biomaterials, have to sort out the main variables and constraints operating in the natural world and are gradually able to confront them with the variables and constraints of technological design. In reality, we take inspiration from our understanding of nature, which in itself is inspired from the dominant technological paradigms of our time. »

7. Jocelyn Maclure et Marie-Noëlle Saint-Pierre (novembre 2018). Le nouvel âge de l’intelligence artificielle : une synthèse des enjeux éthiques. Les Cahiers de propriété intellectuelle, volume 30, numéro 3. Repéré à http://www.ethique.gouv.qc.ca/fr/projets-en-cours/intelligence-artificielle.html

8. Stemmer Imaging. Apprentissage automatique et deep learning. Repéré à https://www.stemmer-imaging.com/fr-fr/conseil-techniqu/apprentissage-automatique-et-apprentissage-profond/

9. Jocelyn Maclure et Marie-Noëlle Saint-Pierre (novembre 2018). Le nouvel âge de l’intelligence artificielle : une synthèse des enjeux éthiques. Les Cahiers de propriété intellectuelle, volume 30, numéro 3. Repéré à http://www.ethique.gouv.qc.ca/fr/projets-en-cours/intelligence-artificielle.html

10. Voir le chapitre 4 de Milad Doueihi (2011). Pour un humanisme numérique. Paris : Éditions du Seuil, 177 pages.

Merci à Charles Blattberg, Guadalupe González Diéguez et Francisco Antonio Loiola pour leurs précieux commentaires sur les ébauches de cette réflexion philosophique. La version originale de cet article a été publiée sur La Conversation.

« Self-plagiarism is style » disait Hitchcock.